La loi binomiale

Une enquête criminelle

Dans les enquêtes criminelles, la procédure dite de « tapissage » (ou de présentation de suspects à des témoins) est parfois utilisée par la police pour identifier un criminel. Mais la question se pose de savoir si une telle procédure est valide : ne peut-on influencer la réponse d'un témoin juste par la manière de présenter les suspects ?

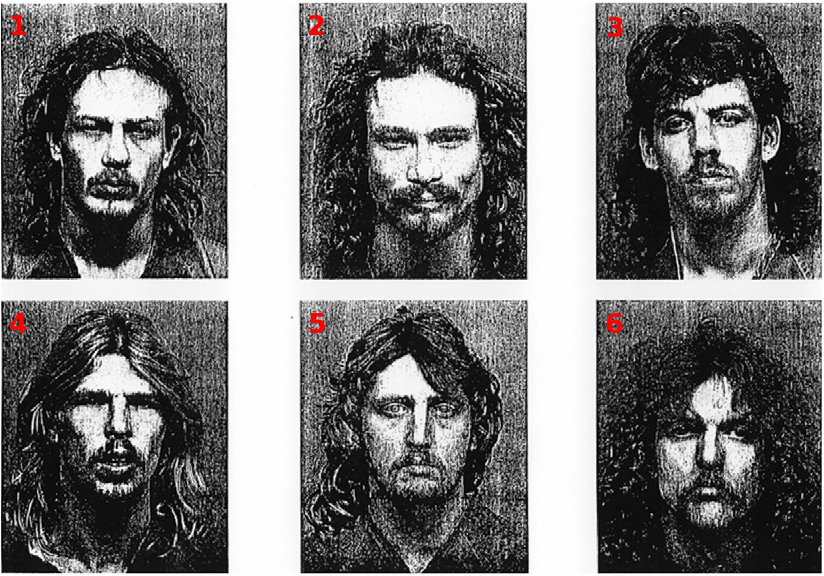

Pour tester la validité de cette procédure, Busey & Loftus (2006) ont présenté la photo d'un criminel dans une affaire réelle, à côté de 5 autres photos, à des sujets qui n'ont en réalité absolument rien vu du crime. On leur demande de repérer le coupable sans aucune autre information.

Si des sujets qui n'ont rien vu sont capables de désigner le coupable, c'est que leur réponse est influencée par des éléments de la présentation, ce qui est un problème. Dans l'atelier qui suit, on vous propose de passer vous-mêmes cette expérience.

Atelier 1 : détection d'un coupable

-

expand_moreDebrief

Dans l'expérience de Busey & Loftus (2006), 40 personnes ont été interrogées. Parmi elles, 14 personnes ont désigné le vrai coupable, alors qu'elle n'avaient aucune information préalable. Cela correspond à une fréquence de bonne détection de $f=\frac{14}{40}=0.35$.

Bien sûr ce n'est pas 100% des sujets mais c'est quand même non négligeable. Si nous trouvons que c'est beaucoup, cela signifierait qu'un certain nombre de sujets trouvent dans les photos des éléments suffisants pour pouvoir identifier le vrai coupable. Si nous trouvons que ce n'est pas tant que cela, nous dirons que les sujets qui ont détecté le coupable ont juste eu de la chance. Pour juger de l'amplitude de cette valeur, nous pouvons prendre un point de repère qui est la probabilité de désigner le vrai coupable juste par chance : celle-ci est de $\pi_0=\frac{1}{6}$ (prononcer «pi zéro»), soit environ 0.17.

Attention : cette probabilité est conditionnelle. C'est la probabilité de détecter le vrai coupable si on a seulement eu de la chance. La vraie probabilité, que nous nommerons $\pi$ (prononcer «pi») est pour l'instant inconnue et $\pi_0$ est une valeur candidate purement hypothétique pour $\pi$.

La fréquence observée $f=0.35$ est bien entendu supérieure à la probabilité théorique $\pi_0=0.17$ (selon le scénario chance) de trouver le coupable, mais nous devons nous méfier de la comparaison de deux objets aussi différents qu'une fréquence et une probabilité. Dans l'exercice du lancer du dé , nous avons bien vu qu'alors que la probabilité d'apparition du 6 (par exemple) était réellement de 1/6, la fréquence d'apparition du 6 n'était jamais exactement égale à 1/6 (parfois supérieure, parfois inférieure). La fréquence s'approchait de la vraie valeur à deux décimales près à partir de près de deux mille essais...

Ici, nous n'avons que 40 sujets et l'estimation que nous obtenons de la probabilité inconnue $\pi$ de bonne détection peut très bien être assez différente de la vraie valeur. C'est ce qu'on appelle l'erreur d'échantillonnage : nos estimations sont toujours (un peu) erronées sur un échantillon de taille réduite.

Dans ce contexte toute la question est alors la suivante : au vu de la fréquence empirique (c'est-à-dire observée) $f$, pouvons-nous affirmer que la probabilité inconnue $\pi$ est égale à la probabilité théorique $\pi_0$ du scénario chance ?

Retenez bien ces trois symboles ($f$, $\pi$ et $\pi_0$) car ils correspondent à des entités statistiques distinctes : une fréquence observée, une probabilité vraie inconnue, et une valeur numérique de référence.

La loi binomiale

Dans l'exercice précédent, nous avons réfléchi à la notion de probabilité de bonne détection, à l'échelle d'un seul sujet. Mais nous aurons besoin souvent de pouvoir calculer une probabilité composée de $k>1$ événements. Par exemple, quelle est la probabilité d'avoir exactement $k=14$ détections correctes sur 40 sujets interrogés, si la probabilité élémentaire pour chaque personne est de 1/6 ?

Pour répondre à cette question, nous avons besoin de la loi du produit.

Atelier 2 : découverte de la loi du produit

Lisez avec attention l'encadré ci-dessous sur la loi du produit. Appliquez ce résultat fondamental aux situations qui vous sont proposées.

Si deux événements sont indépendants (la survenue de l'un, par influence directe ou cause commune, n'impacte pas la survenue de l'autre), la probabilité qu'ils surviennent ensemble est le produit de leurs probabilités séparées.

Pour deux événements nommés $E_1$ et $E_2$, on écrit symboliquement leur probabilité conjointe comme : $$P(E_1\cap E_2)=P(E_1)\times P(E_2)$$

La loi du produit se généralise pour un nombre quelconque $N$ d'événements

-

expand_moreSynthèse théorique

En répondant aux questions de cet exercice, vous avez revu les éléments suivants :

- Loi du produit : on peut calculer la probabilité globale de toute séquence d'événements indépendants en multipliant toutes les probabilités des événements qui la composent.

- Evénements binaires : dans le cas particuliers des événements binaires (succès/échec, oui/non, reconnaître le coupable ou non), si on désigne par $\pi_0$ la probabilité de réussite, la probabilité de toute séquence particulière comprenant $k$ succès sur $N$ observations (et par conséquent $N-k$ échecs) s'écrit : $\pi_0^{k}(1-\pi_0)^{N-k}$.

- Probabilité d'un certain comptage : par contre, si l'on s'intéresse à une probabilité plus générale qui est la probabilité d'avoir $k$ succès, toutes manières d'y arriver confondues, il faut prendre en compte tous ces scénarios dans une probabilité globale. Par exemple, sur 3 sujets interrogés, si l'on veut calculer la probabilité d'en voir un seulement détecter le coupable, cela peut arriver de 3 manières différentes : soit c'est le premier, soit c'est le deuxième, soit c'est le troisième. Les probabilités de ces 3 séquences possibles sont : $$\begin{aligned} \pi_0(1-\pi_0)(1-\pi_0) &=\pi_0^{1}(1-\pi_0)^{2} \\ (1-\pi_0)\pi_0(1-\pi_0) &=\pi_0^{1}(1-\pi_0)^{2} \\ (1-\pi_0)(1-\pi_0)\pi_0 &= \pi_0^{1}(1-\pi_0)^{2} \end{aligned}$$ Comme on le voit, ces 3 séquences ont la même probabilité, et pour prendre en compte ces 3 scénarios, il nous faut les additionner. En notant $X$ la variable aléatoire «nombre de succès», on écrit : $$\begin{aligned} P(X=1) &=\pi_0^{1}(1-\pi_0)^{2}+\pi_0^{1}(1-\pi_0)^{2}+\pi_0^{1}(1-\pi_0)^{2} \\ &= 3\times \pi_0^{1}(1-\pi_0)^{2} \end{aligned}$$

- Loi binomiale : d'une façon générale, la probabilité de

voir

survenir $k$ fois un événement sur $N$ observations, est décrite par l'expression générale

suivante : $$\boxed{P(X=k)=C_{N}^{k} \pi_0^{k}(1-\pi_0)^{N-k}}$$ ou $C_{N}^{k}$ désigne en

symboles le nombre de manières qu'il y a d'observer $k$ événements-cible sur $N$ observations.

En abrégé, pour affirmer que $X$ suit une loi binomiale, on peut aussi écrire : $$X\sim

\mathcal{B}(N,\pi_0) $$

C'est ce qu'on appelle la loi binomiale, qui est un modèle de distribution à deux paramètres (un effectif et une probabilité). On voit que pour parvenir à cette expression, nous avons dû supposer deux choses : i) une même probabilité $\pi_0$ pour tout le monde, ii) des réponses indépendantes. Il nous faudra bien argumenter ces deux points dans les applications que nous en ferons.

Modèle de l'échantillonnage d'une proportion

La loi binomiale est un exemple de ce que l'on appelle une distribution théorique de probabilités, ou encore une loi de probabilité. Cette loi particulière nous permet de calculer la probabilité d'avoir une certaine fréquence observée $f$ de l'évémement-cible, pour une probabilité théorique fixée $\pi_0$. Elle permet donc de faire le lien entre une probabilité vraie et une fréquence observée.

L'atelier qui suit vise à vous faire saisir ce lien.

Atelier 3 : notion d'échantillonnage sur une proportion.

Dans le graphique ci-dessous, la hauteur des bâtons vous montre avec quelle probabilité la détection du coupable peut arriver un certain nombre de fois (0, 1, 2, ..., 40), selon la loi binomiale. Vous pouvez passer votre souris sur le sommet des bâtons pour avoir les valeurs numériques de ces probabilités. Vous pouvez aussi cliquer-et-tirer avec votre souris pour sélectionner un ensemble de sommets contenus dans un rectangle et obtenir la probabilité additionnée correspondante. Remarque : en sélectionnant les sommets les plus bas, vous pouvez obtenir une addition des probabilités aux deux extrémités de la distribution.

-

expand_moreSynthèse théorique

En répondant aux questions de cet exercice, vous avez appris ou revu les concepts suivants :

- la vraisemblance d'un modèle : c'est la probabilité des

données

observées (pour nous ici la fréquence 14/40) d'après un certain modèle de distribution, incluant une hypothèse sur un de ses paramètres

(pour nous ici l'hypothèse de la pure chance qui se traduit par $\pi=\pi_0=\frac{1}{6}$).

La vraisemblance est une mesure naturelle de la qualité d'une hypothèse. Si cette hypothèse est bonne, elle devrait nous dire que les données qu'on a sont, selon elle, très fortement probables. A l'inverse, si elle nous annonce comme peu probables des données que nous avons pourtant obtenues, nous commencerons à douter de la qualité de ce modèle ou de cette hypothèse. On note $L$ cette mesure (de l'anglais likelihood).

- la valeur p : c'est la

probabilité d'avoir des données aussi extrêmes que celles qu'on a observées.

Elle se distingue de la vraisemblance en ne calculant pas seulement la probabilité des données

observées (14/40), mais également de toutes celles qui sont plus extrêmes, c'est-à-dire moins

probables (15/40, 16/40, etc.). C'est une autre mesure couramment utilisée en psychologie pour

juger de la qualité d'une hypothèse. En notant $X$ la variable «nombre de bonnes

reconnaissances», on a ici $p=P(X\geq 14)=0.0039$ ce qui est une valeur très

faible (on en juge par rapport à un seuil arbitraire de $\alpha=0.05$). Dans cette expérience,

on dira donc que la probabilité de détecter le vrai coupable n'est pas de 1/6, mais une valeur

plus grande que cela, avec moins de 5% de chances de se tromper en l'affirmant.

Attention : les résultats plus extrêmes seront dans certains cas pris en compte aux deux extrémités de la distribution (voir exercice 1 de la section 4).

- l'estimation au maximum de la vraisemblance : quand on ne connaît pas la vraie valeur $\pi$ d'une probabilité, on peut chercher la valeur $\hat{\pi}$ (avec un chapeau) qu'il faudrait lui donner pour que la fréquence concrètement observée apparaisse comme la plus probable. On appelle cette méthode l'estimation au maximum de la vraisemblance. Dans l'exercice nous avons trouvé $\hat{\pi}=0.35$, c'est-à-dire très exactement la valeur de fréquence que nous observons. Ce n'est pas une coïncidence : dans un modèle binomial, la valeur de $\pi$ la plus vraisemblable est toujours celle de la fréquence observée.

La loi binomiale est un modèle d'échantillonnage : elle décrit comment fluctue et varie une fréquence empirique quand on tente de mesurer une probabilité inconnue sur un échantillon restreint de données. En modélisant ce lien aléatoire entre probabilité vraie et fréquence observée, nous espérons à terme pourvoir, à l'inverse, dire quelque chose d'une probabilité inconnue en connaissant simplement une fréquence échantillonnée.

- la vraisemblance d'un modèle : c'est la probabilité des

données

observées (pour nous ici la fréquence 14/40) d'après un certain modèle de distribution, incluant une hypothèse sur un de ses paramètres

(pour nous ici l'hypothèse de la pure chance qui se traduit par $\pi=\pi_0=\frac{1}{6}$).

Exercices d'application

Exercice 1 : la force de l'esprit sur la matière

Une personne affirme pouvoir agir sur la matière par la force de sa pensée. Elle se dit capable de faire en sorte que sur une série de lancers de pièce, l'une des faces (elle ne sait par contre dire laquelle à l'avance) apparaisse plus souvent que l'autre. Pour nous le démontrer, elle lance 10 fois de suite une pièce qui tombe 7 fois sur le côté pile. Diriez-vous que cette personne est bien dotée du pouvoir qu'elle prétend ?

-

expand_moreCorrection

En répondant aux questions de cet exercice, vous avez appris ou revu les concepts suivants :

- la notion d'hypothèse nulle : pour pouvoir raisonner sur cette situation en ne sachant pas ce qui s'y passe vraiment, nous avons besoin de poser un premier scénario hypothétique, qui a l'avantage de permettre de calculer. En supposant que la personne a simplement eu de la chance ($\pi=\frac{1}{2}$), nous pouvons nous faire une idée des résultats plausibles sous cette hypothèse.

- la notion de valeur p : c'est la probabilité d'avoir des données aussi extrêmes que celles qu'on a observées, d'après l'hypothèse nulle. Dans cette expérience, les données aussi extrêmes que celles observées sont tous les résultats qui peuvent nous conduire à rejeter l'hypothèse nulle. Deux scénarios ici sont dans ce cas : une longue série de pile ($k$ observé élevé), ou une longue série de face ($k$ observé faible). La valeur $p$ est donc calculée en cumulant les probabilités des résultats extrêmes aux deux bouts de la distribution : $$\begin{aligned}p &= P(X\leq 3|H_0) + P(X\geq 7|H_0) \\ &= P(0)+P(1)+P(2)+P(3)+P(7)+P(8)+P(9)+P(10) \end{aligned}$$ Pour accélerer les calculs, on peut noter que pour $\pi=0.5$, la loi binomiale a une forme parfaitement symétrique ($P(7)=P(3)$ par exemple). On a donc plus rapidement : $$\begin{aligned}p &= P(X\leq 3|H_0) + P(X\geq 7|H_0) \\ &= P(X\leq 3|H_0)\times 2 \\ &= (0.1172+0.0439+0.0098+0.0010)\times 2 \\ &= 0.34375 \end{aligned}$$ On obtient automatiquement cette valeur à partir du graphique binomial interactif ci-dessus, en sélectionnant avec la souris les bâtons correspondants à ces valeurs extrêmes.

- la notion de seuil de décision : pour juger qu'un résultat

est peu

probable sous une certain hypothèse, il nous faut un repère arbitraire de ce que nous

considérerons

comme petit ou grand, en termes de probabilité cumulée. En psychologie, on utilise historiquement

le

seuil $\alpha=0.05$. La valeur $p=0.3438$ est clairement supérieure au seuil $\alpha$ : on ne peut

pas

rejeter l'hypothèse de la chance seule.

Attention : ne pas pouvoir rejeter une hypothèse ne veut pas dire qu'elle s'en trouve prouvée. On peut simplement dire à la personne que ces résultats ne sont pas suffisamment surprenants (c'est-à-dire improbables) pour qu'elle puisse nous convaincre.

Cette méthode de décision par valeur $p$ est la plus répandue en psychologie. Elle a cependant des limites et nous apprendrons à utiliser une approche plus flexible, basée sur la vraisemblance.

Exercice 2 : schizophrénie et graphologie

Pascal & Suttel (1947) ont rapporté qu'une graphologue prétendait pouvoir diagnostiquer la schizophrénie à travers l'écriture. Il lui ont fait examiner dix documents dont 5 avaient été rédigés par une personne schizophrène et cinq par une personne normale. Elle a identifié correctement le type de personne (schizophrène ou non) dans 6 cas sur 10. Que pensez-vous de ce résultat ?

-

expand_moreCorrectionEn répondant aux questions de cet exercice, vous avez appris ou revu la notion de valeur $p$ calculée unilatéralement (par opposition au calcul bilatéral de l'exercice précédent). Ici, la probabilité d'avoir des données aussi extrêmes que celles qu'on a observées revient à regarder les fréquences de réussite égales ou plus grandes encore que 6/10. On calcule : : $$\begin{aligned}p &= P(X\geq 6|H_0) \\ &= P(6)+P(7)+P(8)+P(9)+P(10) \\ &=0.377 \end{aligned}$$ Cette valeur est clairement supérieure au seuil $\alpha=0.05$ : on ne peut pas rejeter l'hypothèse de la chance seule.